چرا مکانیزمهای سنتی تحلیل دادهها دیگر کارایی سابق را ندارند؟ در شماره گذشته مراحل و فرآیندهایی را که فرایند داده کاوی ما را به سرانجام میرسانند، بررسی کردیم. همانطور که اشاره شد، جمعآوری و پیشپردازش دادهها از مراحل مهمی هستند که باید در زمان ساخت مدل به دقت انجام شوند.

با ورود به عصر اطلاعات دیجیتال، به یکباره با مشکل شگفتانگیز پیدایش بیش از حد دادهها روبرو شدیم. توانایی ما در تجزیه و تحلیل و درک مجموعههای عظیم دادهها در مقایسه با توانایی ما در جمعآوری و ذخیرهسازی دادهها محدودتر است و مشکل مکانیزمهای سنتی تحلیل داده ها نیز همین است.

پیشرفتهای اخیر در محاسبات، ارتباطات و فناوریهای ذخیرهساز دیجیتال، همراه با توسعه فناوریهای دستیابی به توان بالا باعث شده تا سازمانها و حتی کاربران عادی بتوانند به راحتی حجم باورنکردنی از دادهها را جمعآوری و ذخیرهسازی کنند.

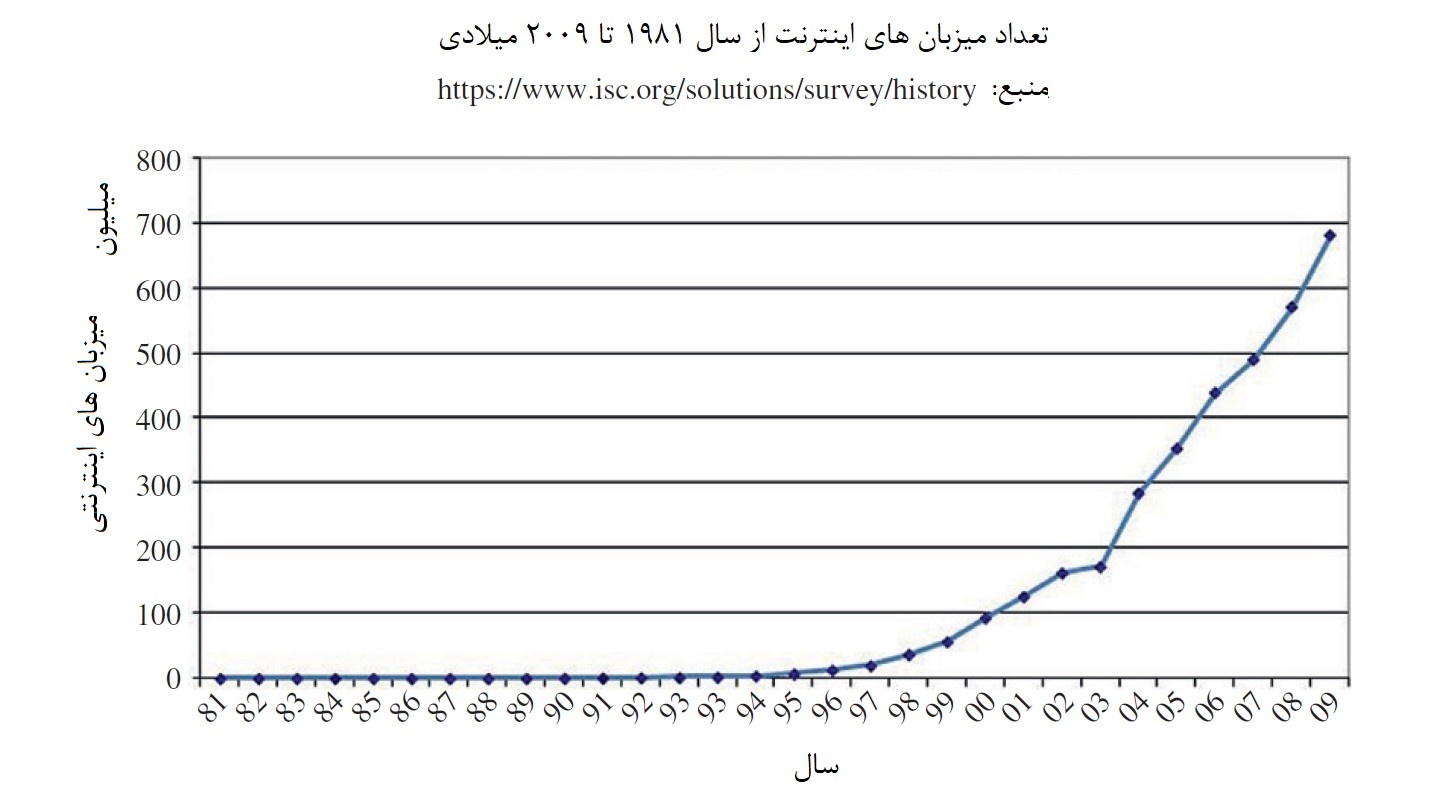

به همین دلیل است که همه جا با پایگاههای اطلاعاتی بزرگ متشکل از اطلاعات دیجیتال رو به رو هستیم. شکل زیر رشد چشمگیر میزبانهای اینترنتی از دهه 80 میلادی تا سال 2009 میلادی را نشان میدهد.

همانگونه که مشاهده میکنید تعداد میزبانهای اینترنتی به یکباره از سال 2003 میلادی تا سال 2009 میلادی رشد چشمگیری داشتهاند.

پیشنهاد مقاله: چرا آموزش داده کاوی مهم است؟

از جمعآوری دادهها تا پیشپردازش دادهها

ثبت تراکنشهای فروشگاههای محلی، اطلاعات مربوط به خرید از طریق دستگاههای پوز، سوابق موجود در مطب پزشکان، الگوهای تماس تلفنی و انواع مختلف فعالیتهای آنلاین، باعث پدید آمدن سوابق دیجیتالی میشوند که درون پایگاههای تجاری بزرگ ذخیره میشوند.

به عنوان مثال، سیستمهای رایانهای پیچیده، شبکههای ارتباطی و سیستمهای تامین انرژی مجهز به حسگر و دستگاههای اندازهگیری که دادههای مختلفی را با هدف سهولت بر نظارت، کنترل و بهبود عملکردهایشان جمعآوری و ذخیرهسازی میکنند، حجم قابل توجهی از اطلاعات را تولید میکنند.

اما در پایان، این متخصصان و دانشمندان هستند که با استفاده از زیرساختهای سنجش از راه دور، دادههای جمعآوری شده از منابع مختلف را تحلیل میکنند. این تحلیل و ارزیابی میتواند کاوش میکروسکوپی در مورد جزئیات تعدادی سلول زنده یا ارزیابی عملکرد ماشینآلات باشد.

ابزارهای علمی میتوانند به راحتی در مدت زمان کوتاهی چندین ترابایت داده تولید کرده و در کامپیوترها ذخیره کنند. یک نمونه روشن در این زمینه، صدها ترابایت DNA، توالی پروتئینها و دادههای توصیفکننده ژنها است که محققان علوم زیستشناسی جمعآوری کردهاند.

عصر اطلاعات با گسترش اینترنت باعث رشد چشمگیر منابع اطلاعاتی و همچنین واحدهای ذخیرهسازی اطلاعات شده است. همانگونه که شکل بالا نشان میدهد شاهد افزایش چشمگیر میزبانهای اینترنتی در سالهای اخیر هستیم. این رشد چشمگیر با میزان دادههای ذخیره شده در اینترنت تناسب دارند. به عبارت دقیقتر، افزایش تعداد میزبانهای اینترنتی نشان میدهد که ما بهطور مستمر در حال تولید و ذخیرهسازی اطلاعات هستیم.

تخمین زده شده که جهان دیجیتال در سال 2007 تقریباً 281 اگزابایت داده مصرف کرده و تا سال 2011 این مقدار 10 برابر بیشتر شده است (یک اگزابایت بهطور تقریبی برابر با 1،000،000 ترابایت است.). بهطور مثال، دوربینهای دیجیتالی و ویدیویی ارزان قیمت آرشیو عظیمی از تصاویر و فیلمها را به وجود میآورند.

گسترش روزافزون برچسبهای RFID و فرستنده-گیرندههایی که از آنها برای بررسی وضعیت یا ارسال و دریافت اطلاعات استفاده میشود و به دلیل کم هزینه و کوچک بودن به محصولات مختلف متصل میشوند و بهطور منظم حجم گستردهای از اطلاعات را تولید میکنند، ایمیلها، وبلاگها، دادههای معاملاتی و میلیاردها صفحه وب که روزانه اطلاعاتی در حد ترابایت تولید میکنند، مانع از آن میشوند تا کارشناسان بتوانند به سرعت و با دقت زیاد این اطلاعات را پردازش کنند.

رشد روزافزون اطلاعات باعث شده تا شکاف میان جمعآوری دادهها، سازماندهی دادهها و توانایی در تجزیه و تحلیل دادهها به سرعت زیاد شود. سختافزار و فناوری پایگاههای داده فعلی امکان ذخیرهسازی و دسترسی کارآمد، ارزان و قابل اطمینان دادهها را فراهم میکنند.

با این حال، مهم نیست زمینه فعالیت شما تجاری، پزشکی، علوم زیستی یا دولتی باشد در تمامی موارد، مجموعه دادههایی که به شکل خام در دسترستان قرار دارند ارزش مستقیم کمی دارند. درست مثل آنکه شما تنها نفت خام داشته باشید. در این حالت کاربرد چندانی برای این طلای سیاه پیدا نمیکنید، اما زمانی که ابزارها و دانش کافی در اختیار داشته باشید کاربردهای مختلفی برای این محصول ارزشمند در دسترستان قرار دارد.

آنچه ارزشمند است دانش قابل استنباط از دادهها و استفاده از آنها است. بهطور مثال، پایگاه داده بازاریابی یک شرکت تولیدکننده کالاهای مصرفی ممکن است اطلاعاتی در ارتباط با میزان فروش اقلام خاص و گروههای جمعیتی خاص داشته باشد. از این دانش میتوان برای معرفی کمپینهای بازاریابی هدفمند و جدید با بازدهی مالی قابل پیشبینی به جای پیادهسازی کمپینهای بدون تمرکز استفاده کرد.

چرا تحلیل دادهها دشوار است؟

علت اصلی بروز مشکلات این است که اندازه و ابعاد دادهها برای تجزیه و تحلیل و تفسیر دستی یا حتی برخی تجزیه و تحلیلهای نیمه خودکار مبتنی بر کامپیوتر بسیار زیاد است. یک دانشمند یا یک تاجر میتواند چند صد یا هزار پرونده را به شیوهای کارآمد بررسی و ارزیابی کند. ولی اگر میلیونها نقطه دادهای را که هر یک دهها یا صدها ویژگی توصیفی دارند، به یک کارشناس یا گروهی از کارشناسان بدهید دیگر قادر به تحلیل دقیق اطلاعات نیستند.

بهطور مثال، تصور کنید که قصد تجزیه و تحلیل دادههای ترابایتی مربوط به تصاویر و اجرام آسمانی را دارید. تصاویری که وضوح هر یک از آنها 23040x 23040 پیکسل است. یا فرض کنید میخواهید پایگاه دادههای ژنوم انسانی با میلیاردها مولفه را تحلیل کنید، آیا امکان پردازش دستی چنین اطلاعاتی فراهم است؟

به لحاظ تئوری، بزرگ دادهها (Big Data) میتوانند در نتیجهگیری دقیق و درست، کمک زیادی به ما بکنند، اما زمانی که قصد بهکارگیری این دادهها را دارید مشاهده میکنید که با مشکلات عدیدهای روبرو هستید.

اگر نگاهی به دنیای تجارت و بازارهای اقتصادی داشته باشید به خوبی متوجه میشوید حجم اطلاعاتی که روزانه تولید میشوند بیش از آن است که یک تحلیلگر بتواند به تنهایی آنها را پردازش کند. علاوه بر این، مدیران تجاری به خوبی از این موضوع آگاه هستند، بهطوری که:

- 61٪ از مدیران معتقدند که اضافه بار اطلاعات در محل کار آنها وجود دارد.

- 80٪ معتقدند که اوضاع بدتر خواهد شد.

- بیش از 50٪ از مدیران، به دلیل اضافه بار اطلاعات، دادهها را در فرآیندهای تصمیمگیری فعلی نادیده میگیرند.

- 84٪ از مدیران این اطلاعات را برای آینده ذخیره میکنند و در تجزیه و تحلیل فعلی آنرا کنار میگذارند.

- 60٪ معتقدند که هزینه جمعآوری اطلاعات بیش از ارزش آن است.

پیشنهاد مقاله: بوتکمپ برنامه نویسی بامداد، مسیری دشوار (اما کوتاه) برای ورود به حرفه برنامه نویسی

راهحل چیست؟

پاسخ ساده است، باید کار بیشتری انجام شود، اما برای چه مدت زمانی قادر به انجام اینکار هستیم؟ بهطور معمول وقتی کاری را بهطور مرتب انجام میدهیم، آن هم کاری که نیازمند حجم زیادی از تفکر است، به سرعت با محدودیتهای طبیعی و زیستی روبرو میشویم. در این حالت ممکن است دستیاری را استخدام کنیم تا به ما در انجام کارها کمک کند. البته باید توانایی پرداخت دستمزد او را هم داشته باشیم.

در بلندمدت، برخی دادهها را نادیده میگیرم، اما اینکار باعث میشود در بازار رقابتی موفقیت چندانی به دست نیاوریم. تنها راهحل واقعی جایگزینی روشهای کلاسیک تجزیه و تحلیل و تفسیر دادهها (دستی و رایانهای) با فناوری جدید دادهکاوی است.

به لحاظ تئوری، بیشتر روشهای دادهکاوی با اتکا بر مجموعهای از بزرگ دادهها، نتایج قابل استناد ارائه میکنند. آمارها نشان میدهند که بزرگ دادهها این ظرفیت را دارند که اطلاعات با ارزش تولید کنند.

اگر مدلهای دادهکاوی بر مبنای بررسی احتمالات مختلف پیادهسازی شوند، بزرگ دادهها این قابلیت را دارند تا امکانات بیشتری در اختیار مدلها قرار دهند تا فرآیند سرشماری و ارزیابی به شکل دقیقتری انجام شود. با اینحال، زمانی که سرشماریها و جستوجوها زیاد میشوند با محدودیتهای عملی متوازنسازی این دو مفهوم روبرو میشویم.

علاوه بر پیچیدگی محاسباتی الگوریتمهای دادهکاوی مبتنی بر بزرگ دادهها که قادر به انجام یک جستوجوی کامل و فراگیر هستند ممکن است خطر یافتن برخی راهحلهای کم احتمالتر (کم ارزشتر) که بر مبنای ارزیابی بزرگ دادهها کارآمد شناخته شدهاند را افزایش دهد و در بلندمدت نتایجی ارائه کنند که انتظارات را بر آورده نمیکنند.

در شماره آینده مبحث فوق را ادامه میدهیم.

نویسنده: حمیدرضا تائبی

يك ديدگاه

سلام

تشکر بابت مطالب خوبی که منشتر می کنید، فکر کنم این مطلب ناقصه، ادامش کجا است؟